OpenAI выпустила две рассуждающие модели искусственного интеллекта с открытыми весами — они, утверждает разработчик, обладают возможностям, аналогичным тому, на что способны его модели серии «o». Обе новые открытые модели ИИ доступны на платформе Hugging Face.

Компания предложила две разработки: более мощная модель gpt-oss-120b требует для работы видеокарту Nvidia, а более лёгкой gpt-oss-20b достаточно потребительского ноутбука с 16 Гбайт оперативной памяти. В последний раз OpenAI выпускала открытый проект более пяти лет назад — это была GPT-2. Новые модели, сообщили в компании, могут направлять слишком сложные запросы работающим в облаке системам, если не справляются с какими-либо запросами самостоятельно.

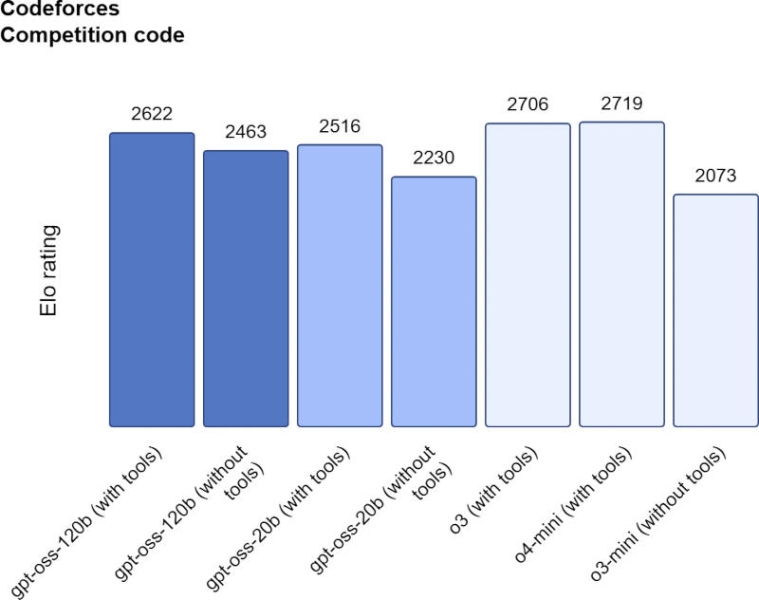

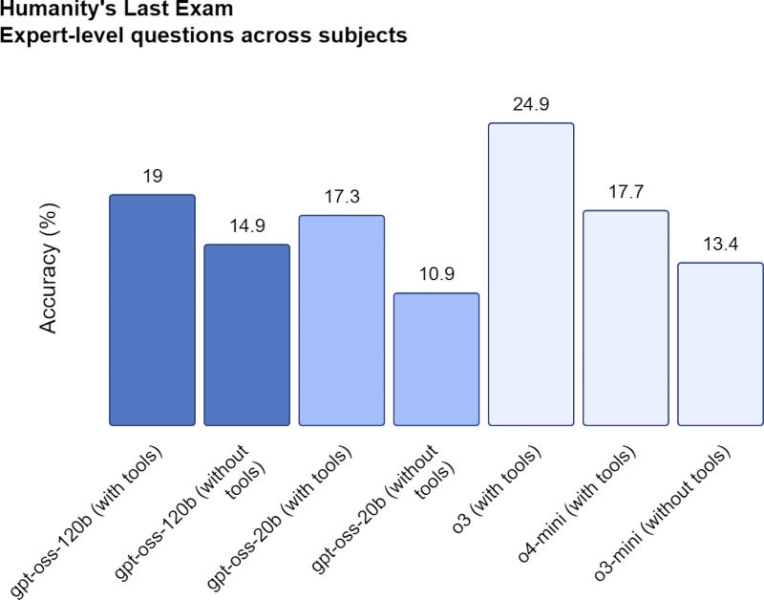

Будучи признанным мировым лидером в отрасли ИИ, OpenAI стремилась сделать свои открытые модели наиболее мощными в сравнении с существующими аналогами, и это ей, по её утверждению, удалось. В тестах платформы Codeforces на написание программного кода модели gpt-oss-120b и gpt-oss-20b набрали 2622 и 2516 баллов соответственно, обойдя DeepSeek R1, но уступив o3 и o4-mini. В бенчмарке Humanity’s Last Exam (HLE) gpt-oss-120b и gpt-oss-20b показали результаты соответственно 19 % и 17,3 % — ниже, чем o3, но выше ведущих открытых моделей DeepSeek и Alibaba Qwen.

Отмечается, что у новых открытых моделей OpenAI галлюцинации, то есть выдаваемые с уверенностью не соответствующие действительности ответы, встречаются чаще, чем у закрытых o3 и o4-mini. Такой результат разработчик назвал «ожидаемым, поскольку модели меньшего размера обладают меньшим знанием мира, чем передовые модели большего размера, и склонны к более выраженным галлюцинациям». В тесте PersonQA модели gpt-oss-120b и gpt-oss-20b галлюцинировали в ответах в 49 % и 53 % случаев соответственно; для сравнения, у o3 и o4-mini эти показатели составляют соответственно 16 % и 36 %.

OpenAI обучала открытые модели, используя те же процессы, что применяются при обучении закрытых — в обеих используется метод MoE (Mixture-of-Experts), позволяющий при ответах на вопросы использовать меньше параметров. Так, у модели gpt-oss-120b всего 177 млрд параметров, но активируются лишь 5,1 млрд на токен, что способствует росту эффективности. При разработке использовалось высокоинтенсивное обучение с подкреплением (high-compute reinforcement learning) — процедура, помогающая отличать правильное от неправильного в моделируемых средах; этот метод применяется при обучении моделей серии «o». Открытые модели также используют схожий процесс обработки ответов, предполагающий выделение дополнительного времени и дополнительных ресурсов.

Открытые модели, утверждают в OpenAI, подходят для работы в составе ИИ-агентов, они способны обращаться к веб-поиску и средствам выполнения кода Python. Подчёркивается, что они не являются мультимодальными, то есть предназначаются только работы с текстом и не могут обрабатывать или генерировать изображения и звук. Модели доступны под лицензией Apache 2.0, которая считается одной из наиболее демократичных. При этом компания отказалась раскрывать, какие данные использовались при их обучении.

OpenAI провела отдельное исследование на предмет того, смогут ли гипотетические злоумышленники использовать их в кибератаках или разработке биологического или химического оружия — при участии сторонних экспертов было установлено, что незначительную помощь в области биологической науки они оказать всё-таки смогут, но доказательств потенциального превышения установленного «порога возможностей» даже после процедуры тонкой настройки обнаружено не было.